分享文章

分享文章

DeepSeek-R1本地部署,再也不怕宕机,还有语音功能!

最近国产大模型DeepSeek特别火,以至于频繁出现反应迟缓甚至宕机的情况,和两年多之前ChatGPT的遭遇颇为相似。

万幸,DeepSeek是一个开源模型,我们大可以通过本地部署,在自己的终端上随时使用!接下来就教大家具体的操作:

一、用Ollama下载模型

首先我们需要安装Ollama,它可以在本地运行和管理大模型。

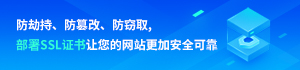

到Ollama官网 https://ollama.com,点击下载,然后选择适合自己系统的版本,这里选择Windows:

下载完成后点击安装,完成后安装窗口会自动关闭,你的系统托盘图标会出现一个常驻的Ollama标记:

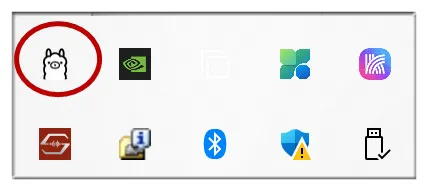

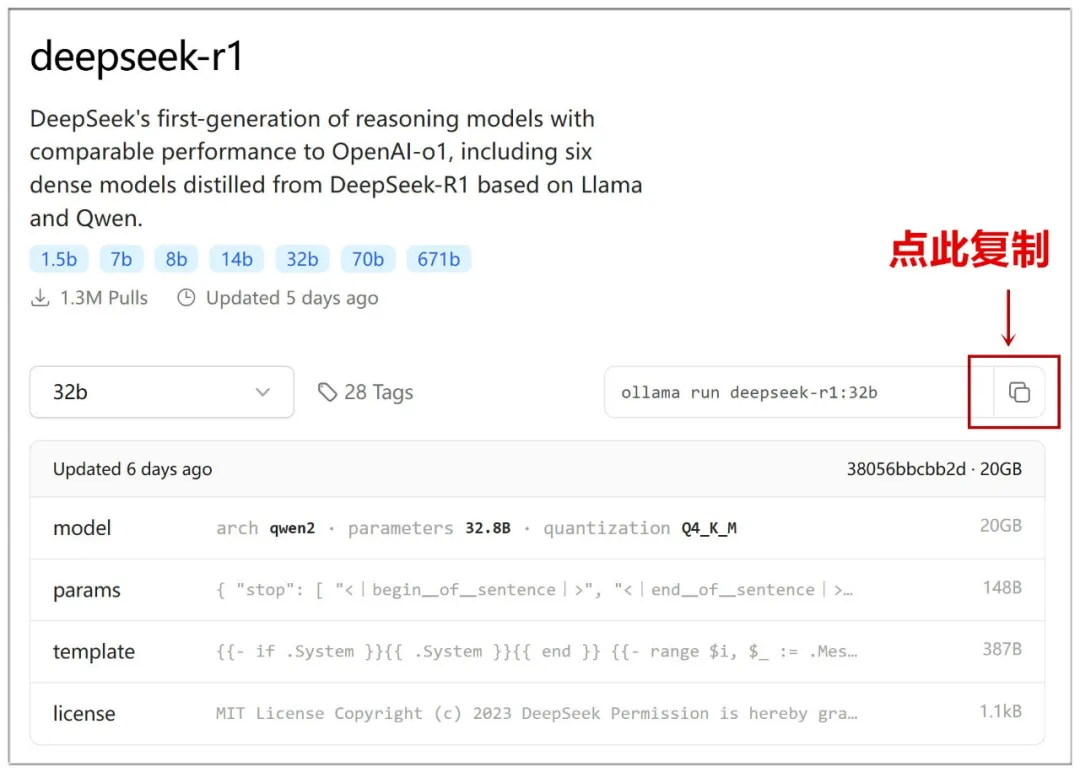

接下来点击Ollama官网左上方的“Models”按钮,会列出支持的各种模型,目前最火的DeepSeek-R1排在显眼位置,点击进入主题页面:

进入这个界面后,点击下拉菜单,可以看到多个版本。我的主机是4090显卡24G显存,选择32b版本(数字越大,对显存要求越高):

选择好模型之后,点击右侧这个按钮,复制指令,这里是:ollama run deepseek-r1:32b

在Windows搜索栏输入“cmd”回车,唤出命令行窗口:

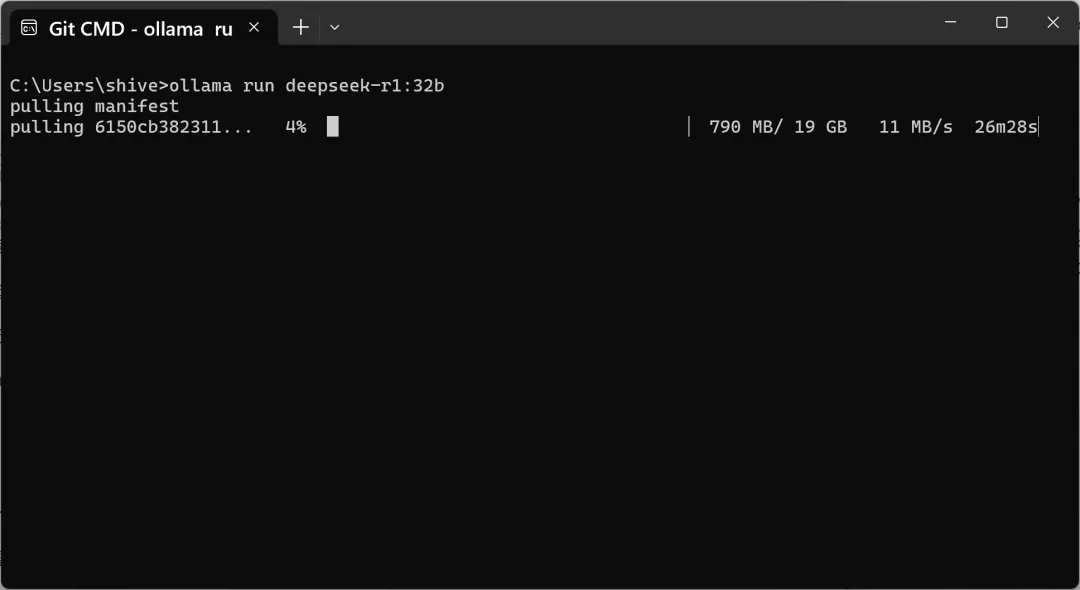

黏贴运行刚才复制的命令,开始下载,32b模型容量大约19GB,请保持网络畅通:

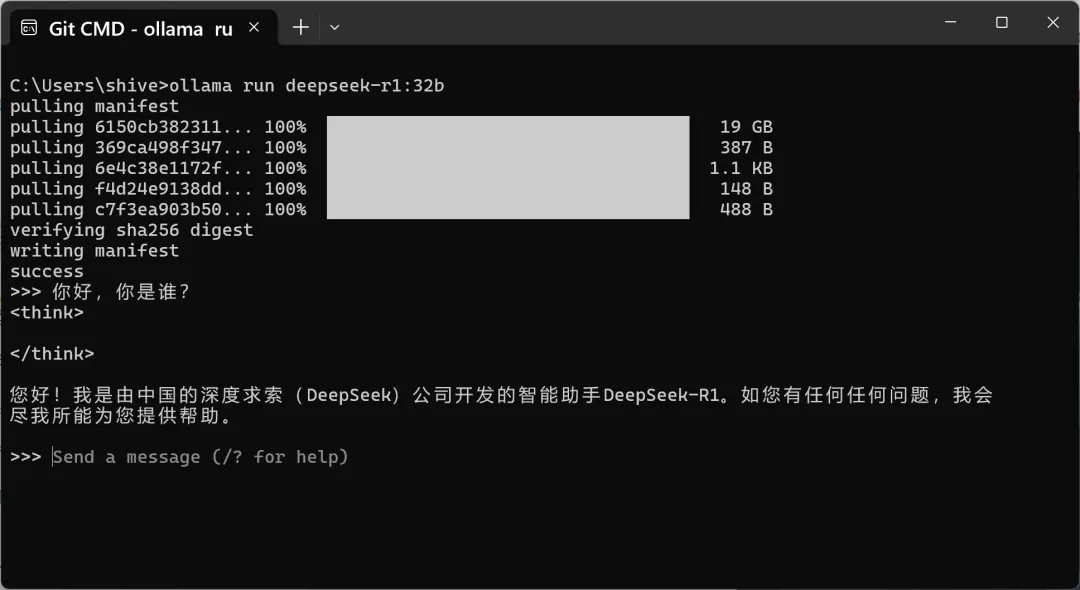

下载完成之后,就可以和DeepSeek对话了:

但是在命令行窗口下对话,还是太抽象,我们需要一个美观的图文交互界面。

二、安装Docker

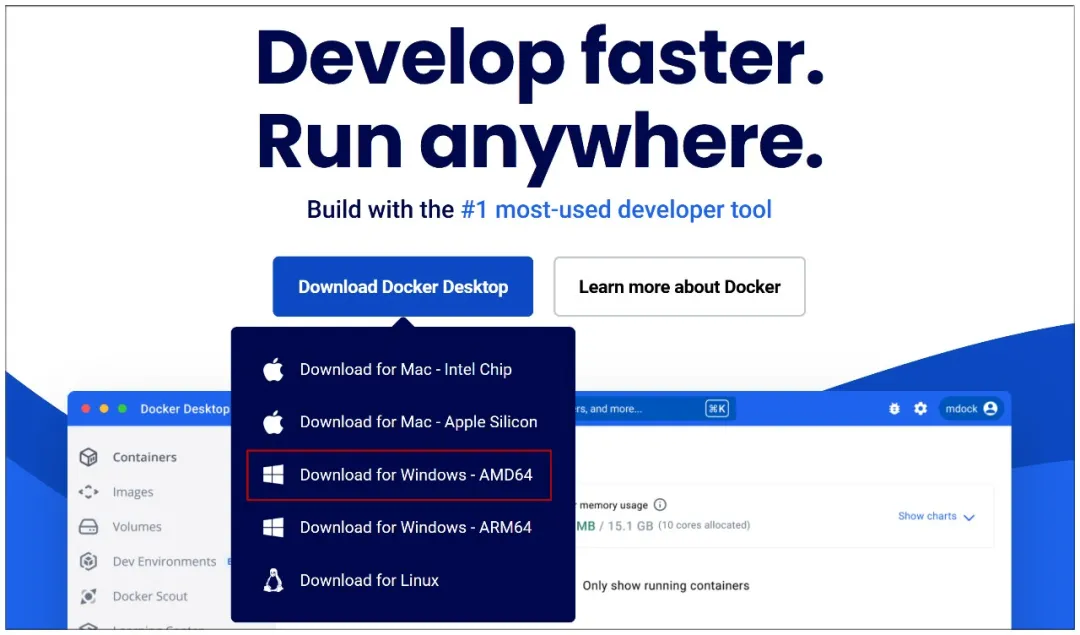

因此要用到Docker这个容器化平台,先从官网 https://www.docker.com 下载,这里依然选择Windows版:

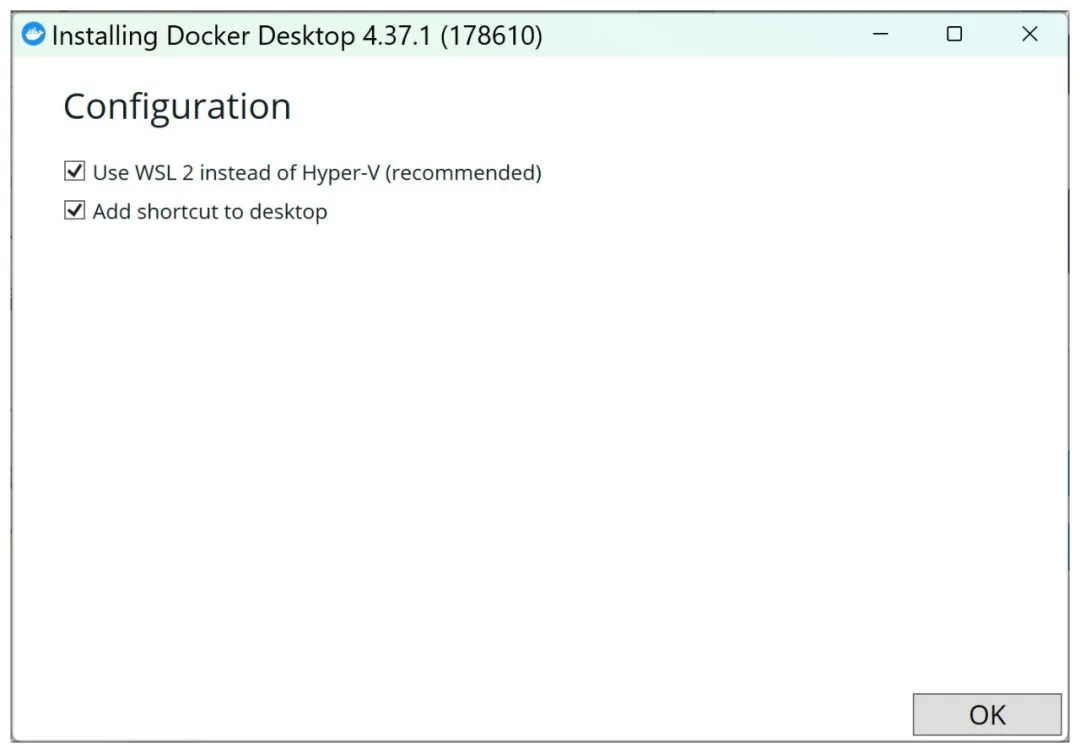

下载后安装,选项全默认即可:

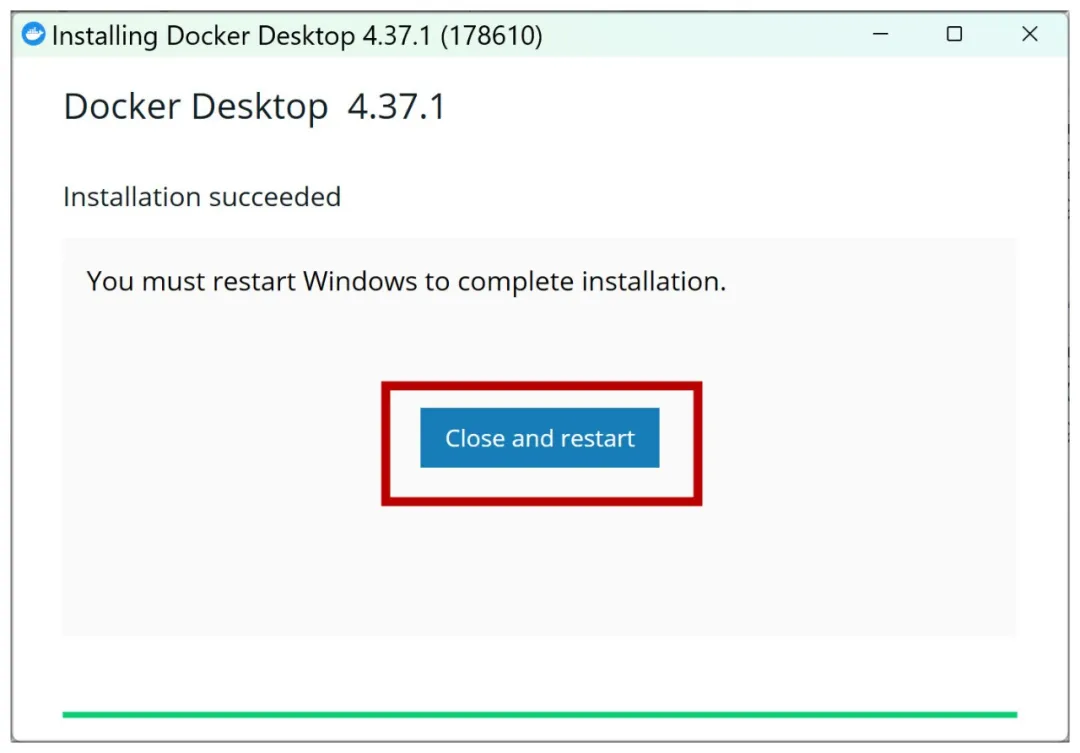

安装完成需要重新启动Windows:

重启后需要同意Docker的条款,并注册你的账号:

三、安装Open WebUI

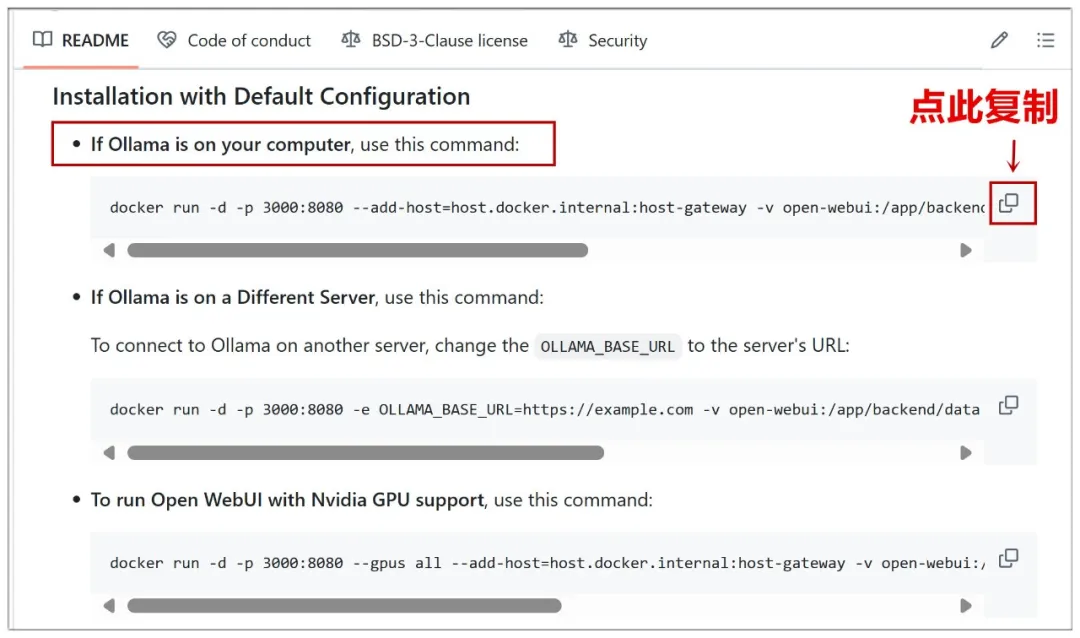

接下来到Open WebUI这个开源工具的代码页:

https://github.com/open-webui/open-webui

找到“If Ollama is on your computer, use this command”这一项,点击右边的按钮复制这个指令:

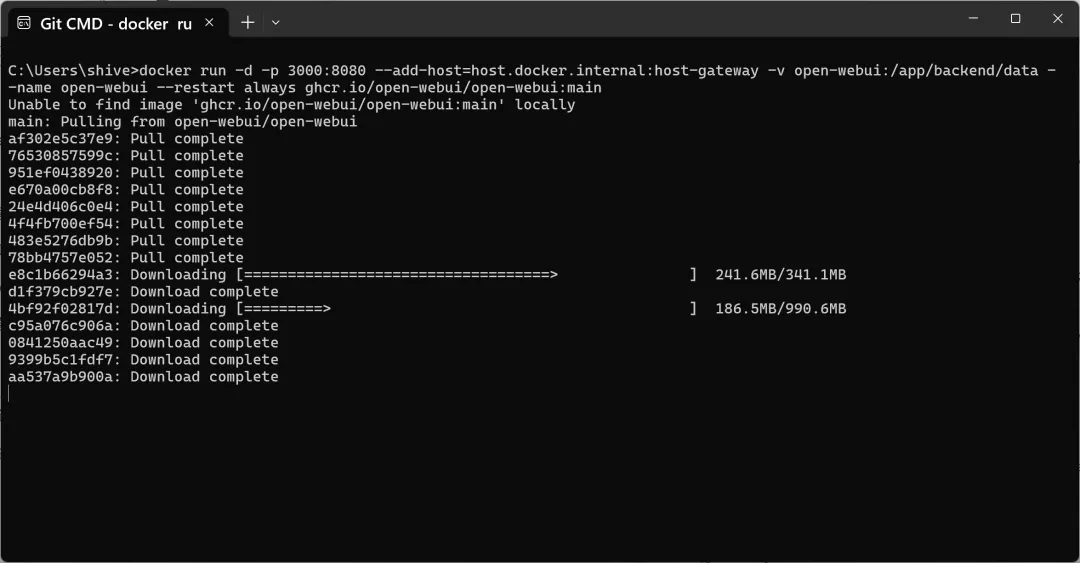

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

再次打开命令行窗口,黏贴刚才复制的命令,安装Open WebUI:

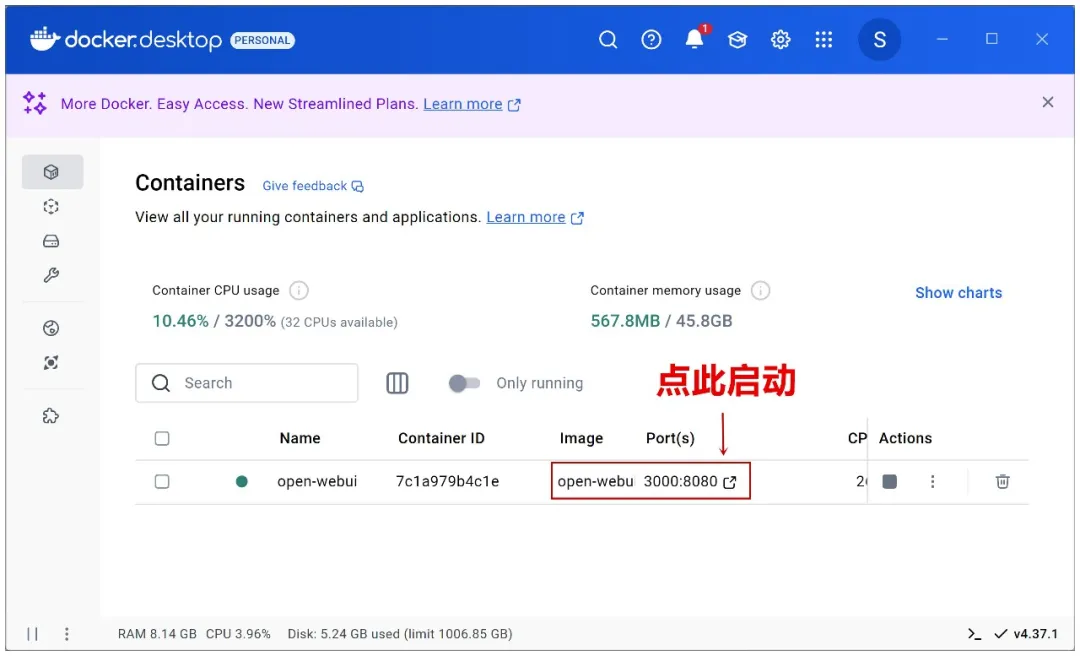

安装完成后,你会发现你的Docker界面里多了Open WebUI的条目。

四、在图形化界面下运行DeepSeek

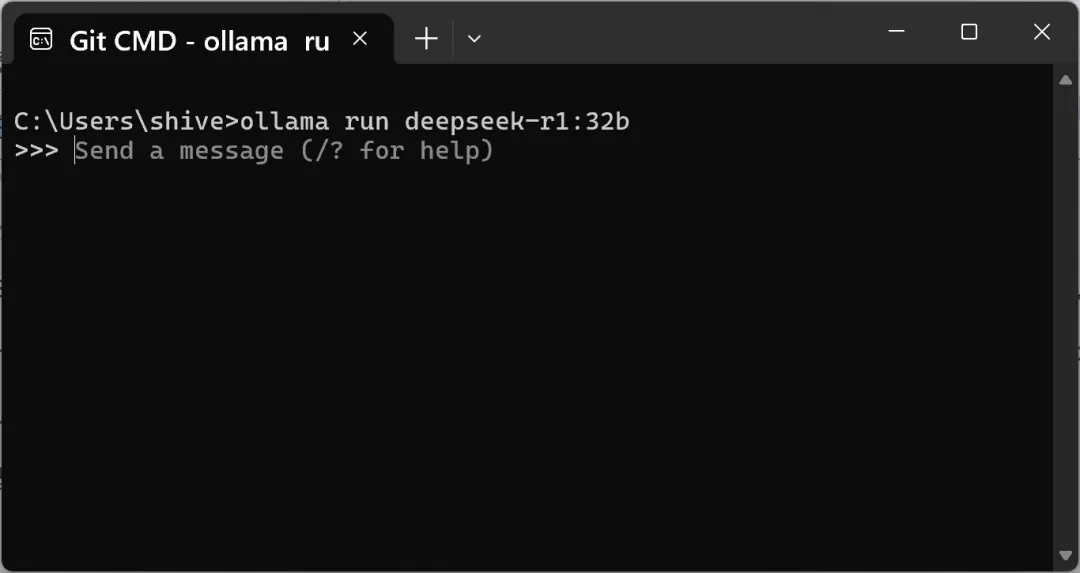

还记得之前装好的Ollama吗?你需要在命令行窗口里再次执行:ollama run deepseek-r1:32b

保持命令行窗口开启,然后点击Docker桌面端的这个位置:

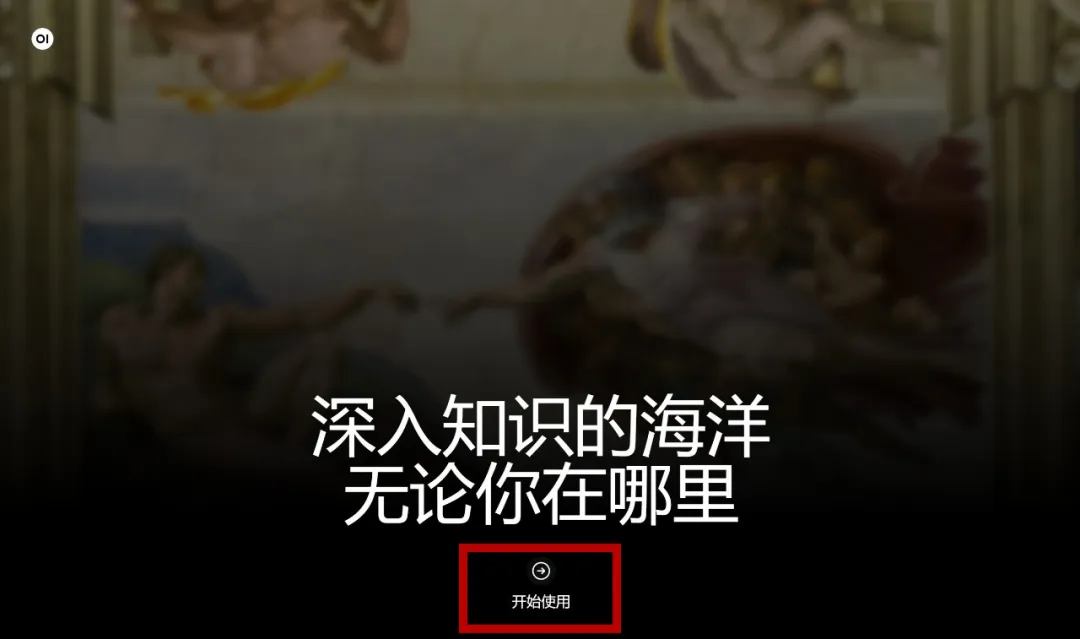

首次使用,会打开一个网页,点击“开始使用”:

把你之前注册的账号名字密码填进去,登录:

这里点击“确认,开始使用”:

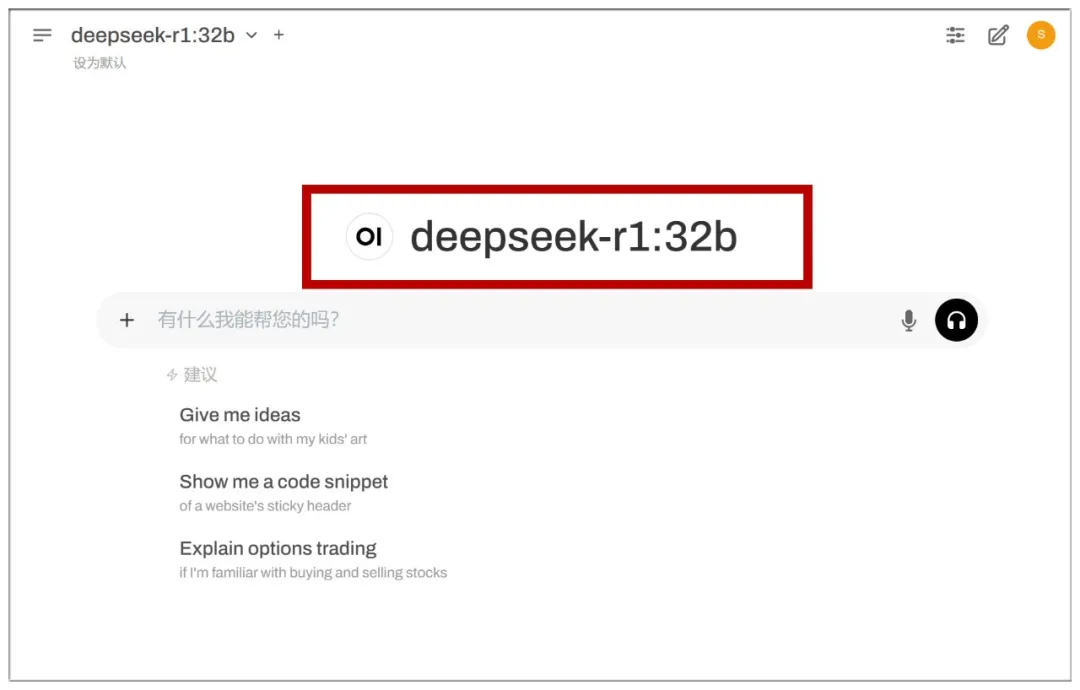

图形界面的DeepSeek-R1,准备就绪,随时待命!

32b的反应速度很快,因为是R1模型,所以有深度思考功能:

更棒的是,还可以通过Open WebUI自带的语音功能输入,避免打字。方法是点击右边的“呼叫”按钮:

DeepSeek会同时输出文字和语音,虽然是机器人腔调,但毕竟是官方也没有的功能!

Enjoy!

文章提到的网址:

Ollama官网:https://ollama.com

Docker官网:https://www.docker.com

Open WebUI的代码页:https://github.com/open-webui/open-webui

[超站]友情链接:

四季很好,只要有你,文娱排行榜:https://www.yaopaiming.com/

关注数据与安全,洞悉企业级服务市场:https://www.ijiandao.com/

关注网络尖刀微信公众号

关注网络尖刀微信公众号随时掌握互联网精彩

- 1 习近平将发表二〇二六年新年贺词 7904141

- 2 2026年国补政策来了 7808738

- 3 东部战区:开火!开火!全部命中! 7712893

- 4 2026年这些民生政策将惠及百姓 7616985

- 5 小学食堂米线过期2.5小时被罚5万 7519709

- 6 解放军喊话驱离台军 原声曝光 7428214

- 7 为博流量直播踩烈士陵墓?绝不姑息 7327605

- 8 每月最高800元!多地发放养老消费券 7238391

- 9 数字人民币升级 1月1日起将计付利息 7141831

- 10 2026年1月1日起 一批新规将施行 7040675

![胡亦瑶 六一快乐快乐呀![耶][爱你] #六一儿童节##大朋友小朋友们儿童节快乐# ](https://imgs.knowsafe.com:8087/img/aideep/2025/7/26/63e9d5bcbd5709ed792fdf12531b3270.jpg?w=204)

妖精动漫

妖精动漫